谷歌和日本大坂大学发布了一项研究,展示了一种将大脑活动转化为音乐的有趣技术。

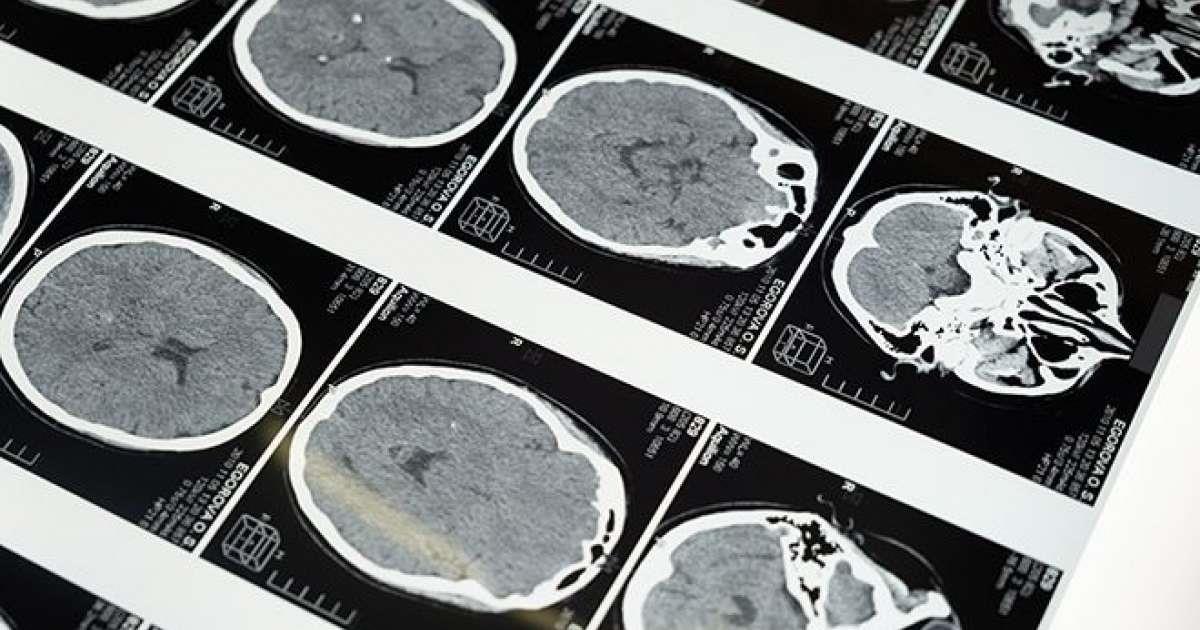

五名志愿者被放入fMRI(功能性磁共振成像)扫描仪中,播放了10种不同音乐风格的500多首曲目。大脑活动创建的图像被捕获并嵌入到谷歌的人工智能音乐生成器Music LM中,这意味着该软件取决于个体的大脑模式和反应。

创作的音乐与受试者接受的刺激相似,但存在微妙的语义差异。该报告的 abstract 他说:“就流派、乐器和情绪等语义属性而言,生成的音乐类似于人类受试者经历的音乐刺激。”

接下来阅读:根据新数据,73%的制作人认为人工智能音乐生成器可以取代他们

该研究还发现,负责“代表源自文本和音乐重叠的信息”的大脑区域存在重叠,并指出两个MusicLM成分与听觉皮质的大脑活动之间存在相似性。

研究人员的研究结果总结说,“当人类和MusicLM接触相同的音乐时,MusicLM的内部表现与某些区域的大脑活动相关。”

它继续说道:“当我们使用来自这些区域的数据作为MusicLM的输入时,我们可以预测和重建人类主体接触过的音乐类型。”

接下来阅读:100多名艺术家签署抵制使用面部识别技术的场馆的承诺

尽管人们认为这样的研究可以让我们更接近通过某种超智能软件将思想转化为音乐,但论文指出,建立一个通用模型将很困难,因为每个人的大脑活动有很大差异。下一步是找到一种纯粹根据人类想象力而不是输入刺激来制作音乐的方法。

查看全文 here ,您还可以在其中收听人工智能生成的音乐。

蒂芙尼·伊贝(Tiffany Ibe)是Mixmag的数字实习生,关注她 Instagram